GPTBot: OpenAI versucht etwas Neues – und lässt Websites jetzt die Wahl

OpenAI sammelt jetzt auch mit einem eigenen Web-Crawler Daten. Den können Website-Betreiber:innen sogar blockieren. Auf Daten aus dem Web, die bereits für das Training von ChatGPT genutzt werden, hat das allerdings keinen Einfluss.

Der GPTBot durchforstet ganz nach dem Vorbild des Google-Bot das Web. Während Google damit den Datenbestand für die gleichnamige Suche sicherstellt, bleibt OpenAI bei Sinn und Zweck des neuen Web-Crawlers hingegen vage.

„Websites, die mit dem GPTBot-Benutzeragenten gecrawlt wurden, können möglicherweise zur Verbesserung künftiger Modelle verwendet werden“, heißt es auf der OpenAI-Website. Mal davon abgesehen, dass sich OpenAI nicht festlegen will, ob die Daten tatsächlich genutzt werden: Grundsätzlich könnten sie als Trainingsdaten herangezogen werden. Website-Betreiber:innen müssen das allerdings nicht hinnehmen.

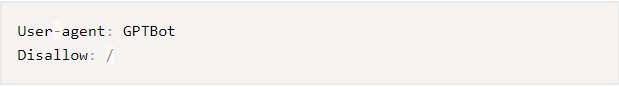

Wer sicherstellen will, dass zukünftige GPT-Versionen nicht anhand von Daten der eigenen Website trainiert werden, kann das durch einen entsprechenden Hinweis in der robots.txt-Datei verhindern.

Das würde dann wie folgt aussehen:

Auf die Datengrundlage von GPT‑4 hat das alles keinen Einfluss

GPT‑4 wurde mit einer Vielzahl von Daten aus dem Web trainiert. Welche genau das waren, verrät das Unternehmen nicht. Klar ist aber, dass die Betreiber:innen der Websites, mit deren Daten das KI-Modell trainiert wurde, weder gefragt wurden, noch die Möglichkeit hatten, die Nutzung zu unterbinden.

Der GPTBot ist aus dieser Perspektive sicherlich ein Fortschritt. Wenngleich Web-Nutzer:innen am Ende auch weiterhin nicht gefragt werden, ob ihre Äußerungen zum KI-Training verwendet werden dürfen. Diese Entscheidung obliegt beim GPTBot allein den Website-Betreiber:innen.

Auch gibt es keine Garantie, dass zukünftige GPT-Modelle ausschließlich anhand der Daten des neuen OpenAI-Crawlers trainiert werden. Es ist durchaus möglich, dass andere Sammlungen von Daten aus dem Web ebenfalls ins Training einfließen.